Pour construire le réseau électrique du futur, pensons Internet. C’est le credo de Bob Metcalfe, l’un des pionniers de l’Internet (1). L’ancien fondateur de 3Com reconverti aujourd’hui dans le capital-risque se penche bien évidemment sur la bulle de green tech qui agite les cerveaux de la Silicon Valley. Et ça décape.

Metcalfe a scotché son monde, la semaine dernière, lors d’une conférence qui rassemblait tout le gotha du high tech à San Francisco. Il devait évoquer les fameux réseaux intelligents, ces smartgrids censés faire communiquer les consommateurs, les appareils et compteurs électriques et les distributeurs de courant.

Aujourd’hui, tout le monde présente les smartgrids comme un moyen d’améliorer l’efficacité des réseaux électriques, dont la conception est séculaire et le gaspillage légendaire. Pour proposer par exemple des tarifs modulés de manière beaucoup plus fine que le traditionnel jour-nuit, pour réduire les besoins aux heures de pointe et éviter le démarrage de centrales coûteuses qui ne marchent que quelques dizaines ou centaines d’heures par an. Une condition aussi pour faire grimper la proportion d’énergies renouvelables —dont la production est souvent aléatoire— dans le mix énergétique mondial. Bref, un outil de pénurie énergétique.

Pour Metcalfe, il faut oublier l’efficacité énergétique, la pénurie, le pic pétrolier et autres poids lourds qui pèsent sur les consciences. Pour lui, l’Internet a été conçu avec plein de bidouilles pour gérer la pénurie de bande passante, en compressant les données, en gérant les aiguillages au plus fin, etc. Et aujourd’hui, nous consommons des millions de fois plus de débit qu’à l’époque. Metcalfe croit dur comme fer que ce futur réseau électrique du XXIe, l’Enernet, transportera aussi des millions de fois plus d’énergie qu’aujourd’hui. Au passage, il considère que le business autour du réchauffement climatique est une bulle. Ce qui ne veut pas dire qu’il conteste le réchauffement. Mais Metcalfe croit dur à la science et à la technologie, qui pourra sauver la planète.

Que penser de cette sortie d’autant plus écoutée qu’elle provient d’un Tycoon de l’Internet? A première vue, on pourrait se dire que Metcalfe a coulé un fusible. Mais à y réfléchir, on se dit qu’il a sans doute toute sa tête. Pour lui, le solaire, la géothermie et même la fusion nucléaire effaceront toutes les inquiétudes sur notre approvisionnement énergétique à long terme. Metcalfe prédit qu’il faudra soixante-deux ans pour bâtir ce fameux réseau électrique intelligent. Et comme le meilleur n’est jamais à exclure, autant imaginer tout de suite un réseau à la hauteur du miracle énergétique, explique Metcalfe.

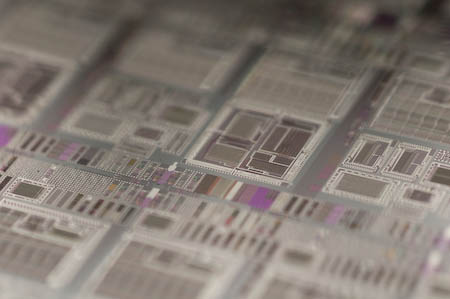

Il a raison et il a tort à la fois. Bien sûr, on ne peut exclure que les recherches conduites aux Etats-Unis et en France (Iter) débouchent un jour sur une source d’énergie dont l’eau serait la matière première. Mais Metcalfe oublie une chose. Même les plus optimistes estiment que la fusion ne pourra répondre avant près d’un siècle à nos besoins. Et d’ici là, il va falloir beaucoup d’énergie pour espérer y parvenir. De la même manière qu’on a eu besoin de supercalculateurs pour inventer le micro-ordinateur, et que les progrès technologiques des puces du moment dépendent de la puissance de calcul dont ont disposait il y a trois ou quatre ans pour les imaginer. Et c’est là où le parallèle entre énergie et informatique s’arrête. Car ce qui a guidé l’industrie de l’information, c’est que chaque étape permettait d’économiser de la matière — le silicium est hors de prix— et de l’énergie. Parce qu’un transistor électronique plus petit occupe moins de place et consomme moins d’énergie. Et en matière de production d’électricité, par exemple, on en est loin.

C’est bien pour cette raison qu’il faut aujourd’hui mettre le paquet sur l’efficacité énergétique. Isoler, réduire la consommation, imaginer un réseau de distribution efficace et faire mentir les oracles qui prédisent la fin de l’ère du pétrole. Parce que si notre civilisation ne se prépare pas au choc qui s’annonce, elle n’aura plus les moyens de préparer son avenir. A supposer que la technologie puisse nous sauver, ce qui n’est pas gagné. Aide-toi, le ciel t’aidera. Et vive les négawatts!

NB. C’est étonnant combien ces réseaux intelligents occupent le devant de la scène au pays d’Obama. Et il y a une catégorie de consommateurs qui se frottent déjà les mains: qui dit réseau électrique informatisé de l’usine au consommateur, dit informatique, logiciel… et piratage. Les hackers sont déjà sur le pont!

(1) On lui doit notamment la technologie Ethernet qui sert à connecter les ordinateurs entre eux ou de brancher les boitiers ADSL pour l’internet.

Salut,

===

les progrès technologiques des puces du moment dépendent de la puissance de calcul dont ont disposait il y a trois ou quatre ans pour les imaginer.

===

Qu’est-ce qui te fait penser cela?

Les architectes de puces, que j’ai pu rencontrer à maintes reprises par le passé, quand je bossais à Science et Vie Micro (SVM). Petite explication (très simplifiée) de la manière dont l’industrie électronique a fonctionné jusqu’il y a peu. Le patron va voir les ingénieurs de procédés pour savoir ce qu’ils seront capables de graver comme puce dans x années (en général trois ou quatre), en terme de finesse et de nombre de transistors. Ça se prévoyait très bien jusqu’à présent grâce à la loi de Moore. Ensuite, le patron va voir les architectes et leur dit: « pour la prochaine génération, vous aurez n transistors, le nombre doublant grosso modo tous les deux ans. Au travail. » C’est là que les simulateurs interviennent: pas facile de modéliser le comportement de cent millions de transistors, voire plus. Si demain un patron annonce un saut spectaculaire, « tu as vingt fois plus de transistors que la dernière fois », plus question de faire ça dans les temps impartis. La loi de Moore, c’est une croissance exponentielle, ça nous promet du bonheur si notre conso d’énergie se met à en faire autant…

Le problème est que cette course est quasiment uniquement alimentée par…les jeux vidéos.

Bien évidemment, tous les chercheurs et organismes qui ont besoin de puissance sont contents que ça progresse, et le dernier bijou d’Intel montre que ça progresse encore beaucoup, même si les procédés de gravure actuels arrivent aux limites physiques. C’est d’ailleurs pourquoi, on a plus ou moins arrêté la course à la fréquence pour rentrer dans la course au nombre de coeurs…au prix d’une énorme complexification des développements de logiciels, mais c’est une autre histoire.

Le problème est qu’on essaie de faire croire au péquin moyen qu’il a besoin des nouveaux matériels pour son usage, alors qu’aujourd’hui, un Core 2 Duo, suffit largement à 90% des gens. Ok, les gens qui font des traitements lourds (3D, vidéos…) ont besoin de peut être plus, mais ça concerne combien de gens ? Je bossais récemment dans une boîte qui fait des technos bien particulières avec des apprentissage de réseaux de neurones etc… et des machines standard suffisaient bien.

Je crois d’ailleurs qu’on le voit bien, le marché du PC/Mac est plus ou moins saturé, tous les constructeurs se ruent sur les Netbook et Smartphone, des machines avec des puissances acceptables, mais qu’on peut optimiser pour qu’elles consomment un minimum. Ca, ça va dans le bon sens.

Mouais… ça va dans le bon sens c’est vite dit. C’est toujours pareil on gagne quelques mini-watts sur la consommation à l’usage mais le processus de fabrication/réparation/recyclage est toujours aussi pourri et dans le même temps le parc de machine ne cesse d’enfler, alors le bon sens… ‘tain j’ai la pêche aujourd’hui moi !

Heureusement qu’un Core 2 Duo ça suffit à 90% des gens (avec un bazooka on peut dégommer toutes les mouches qu’on veut…). Moi je dis une bonne distrib bien optimisée pour M et Mme ToutLeMonde sur un proc mono coeur à 500MHz-1GHz et roule !

Aah ! J’attendais ces mots ! Besoins énergétiques et fusion, mais alors froide s’il vous plait !

C’était, le 23 mars dernier, les 20 ans de la découverte faite par Fleischman et Pons sur la fusion froide donc qui produirait de l’énergie nucléaire peu radioactive et pratiquement sans déchets, ce avec de l’eau lourde et un dispositit cathodique spécial …!

Pour en savoir plus, voir le doc « archives oubliées » de daily motion et le site du cerntea (centre européen pour la recherche et le développement de nouvelles technologies énergétiques alternatives).

C’est passionnant !

Bonne soirée et faite de doux rêves

Bonjour.

J’estime que la consommation annuelle d’un ordinateur, tt compris, avoisine les 1 500 kWh / an. ( 1 )

Si vous êtes chauffé à l’électricité, c’est en gros 10 fois plus.

Une bonne régulation + isolation peut réduire ces 15 000 kWh / an de plusieurs dizaines de %,

soitr plusieurs ordinateurs par foyers.

Merci, Mr Delbecq, d’avoir rappelé cette priorité ds votre article.

( 1 ): 500 W x 2 000 h /an, tt compris.